La tecnología deepfake puede traer palabras de la boca del presidente, devolver la vida a las celebridades e incluso desacreditar a los activistas.

“Deepfakes” podría hacer bailar a la reina Isabel II “TikToks” o devolverle la vida a la princesa Leia de Star Wars. Son vídeos realizados con inteligencia artificial en los que un programa sustituye la cara de una persona por otra, y son tan creíbles que cuesta darse cuenta de que son mentira.

Conoce nuestras vacantes que tenemos disponibles clic aqui…

Visita nuestras Redes Sociales:

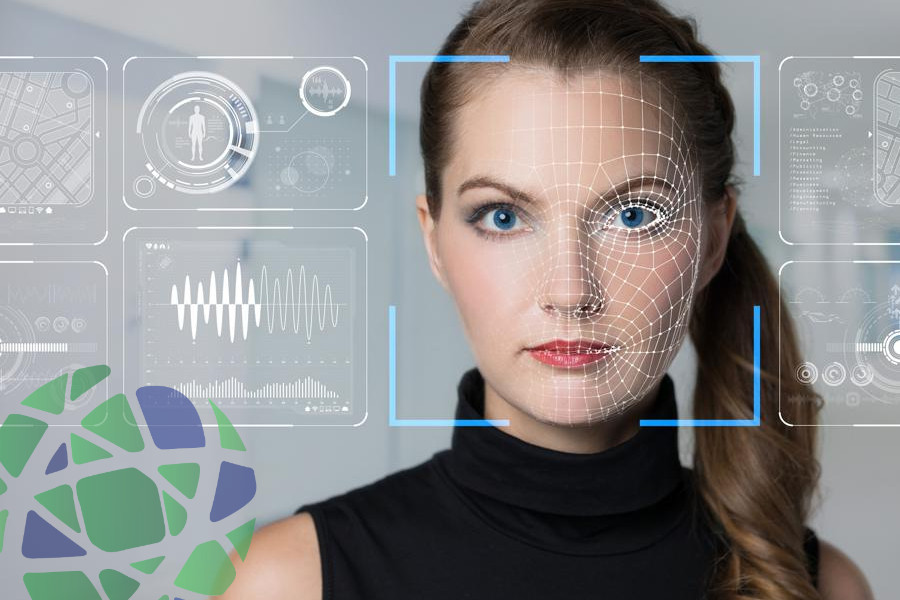

Las imágenes procesadas son generadas por algoritmos que “leen” los rasgos faciales de decenas de fotos y videos tomados desde diferentes ángulos. Con esta información, el programa puede recrear la voz y la imagen de una persona simulando los gestos de una persona en la cara de otra persona.

Resurrección de Celebridades

Los mejores “software” utilizan muchos recursos audiovisuales, cada vez que se crea un “deepfake” van mejorando sus algoritmos para que el siguiente sea mejor, gracias al “aprendizaje automático”, métodos computacionales y estadísticos que permiten a los ordenadores aprender tareas Basado en datos existentes.

Idoia Salazar, presidenta y cofundadora del Observatorio de Ética e Impacto Social de la Inteligencia Artificial (OdiseIA), dijo a Efe que usar “deepfakes” no es necesariamente algo malo per se.

Pueden resucitar a famosos fallecidos, como hizo la cervecería Cruz Campo en un anuncio que devolvía a la vida a la cantante española Lola Flores en minutos, o “sin actores reales en las escenas más peligrosas” de las películas puede ahorrar costos”, agregó el experto.

Armas peligrosas caen en manos equivocadas

Pero en las manos equivocadas, pueden convertirse en vehículos de desinformación de formas más sofisticadas que las mentiras falsas habituales. Pueden emitir comentarios de boca del presidente que causen revuelo público o desacreditar a los activistas haciéndolos aparecer en videos pornográficos falsos.

De hecho, el término “deepfake” fue acuñado en 2017 por un usuario de la plataforma Reddit que usaba el nombre para subir videos de caras de celebridades como Taylor Swift o Gal Gadot en los cuerpos de actrices porno.

Para Salazar, “ahora es necesario un alto nivel de vigilancia” porque “los deepfakes pueden ser muy peligrosos” en términos de desinformación.

Salazar agregó que cuando una persona ve algo escrito, puede intuir por la tipografía que se trata de un contenido modificado, pero cuando una persona ve una imagen que se mueve y se expresa con naturalidad, “casi seguro lo creerá”.

Es difícil distinguir lo que es falso de lo que es real

Por otro lado, la periodista Claire Wardle, cofundadora y directora de First Draft, una organización líder en la lucha contra la desinformación, advirtió en un artículo del New York Times que el “alarmismo” que rodea a los “deepfakes” podría ser explotado por los políticos para rebatir el crimen o conducta reprobable que aparecen en el video.

El expresidente de los Estados Unidos, Donald Trump, por ejemplo, cuestionó si aparecía en un video filtrado antes de las elecciones presidenciales de 2016 en el que se le veía haciendo comentarios groseros sobre las mujeres.

Fue precisamente la línea borrosa entre la verdad y la ficción lo que contribuyó a un intento de golpe en Gabón hace unos tres años. En 2018, el presidente Ali Bongo estuvo ausente del país durante meses, lo que generó rumores sobre su salud.

Después de mucho tiempo, cuando reapareció en el video para dar su discurso de Año Nuevo, sus gestos rígidos y antinaturales le hicieron sospechar que se trataba de una “educación profunda”.

Estas sospechas son un argumento más a favor de la incapacidad del presidente para gobernar, e incluso hay noticias de que está muerto. Una semana después, el ejército intentó un golpe de estado.

The Washington Post, que investigó el video y consultó con expertos en inteligencia artificial, señaló que es probable que sea cierto y que los gestos artificiales son el resultado de un derrame cerebral.

900% de crecimiento

La startup Sentinel ha visto un aumento del 900 % en “deepfakes” desde 2019, de alrededor de 14 500 a 145 000. La mayoría se comparten en las redes sociales y tienen cerca de 6 mil millones de visualizaciones.

El crecimiento acelerado se debe al hecho de que se ha vuelto más fácil crearlos. EFE analiza el “deepfake” de la activista climática Greta Thunberg en el que aparece desnuda. Según el autor anónimo en la descripción del video, las imágenes manipuladas se crearon utilizando una aplicación móvil.

Mientras los países continúan debatiendo su regulación, los expertos insisten en la importancia de la educación en línea y un plan para identificarlos.

El experto en ciberseguridad Juan David Cardona dio a EFE algunos consejos que podrían ayudar a identificarlos, como prestar atención a los gestos de las personas que aparecen en el vídeo, ya que en los “deepfakes” siempre hay un retraso en los fotogramas o en el habla.

También puede haber una acción de cambio de imagen superpuesta, preste atención a los tonos de piel coincidentes entre la cara y el cuerpo.

Por último, aconseja mirar si la fuente de donde proviene el video es conocida y confiable. Si no lo es, buscar si aparece en otras fuentes respetables como periódicos.

Fuente: forbes.com.mx